Spark est un outil qui répond notamment en enjeux liés au big data. Il s'agit d'un framework de calcul distribué qui permet de traiter des volumes de données sur un cluster de machines.

Spark est un outil très pertinent lorsque nous parlons de Big Data; pourquoi ? Car il est permet de paralléliser les calculs sur de gros volumes de données, donc d’aller plus vite. Afin d'entraîner son algorithme, le Data Scientist a souvent besoin d’un volume de données important. Il serait donc tenté d’utiliser Spark. Néanmoins afin de l’utiliser à bon escient il lui est nécessaire de savoir ce qu’est réellement Spark, comment il fonctionne, comment on l’installe et comment on le maintient.

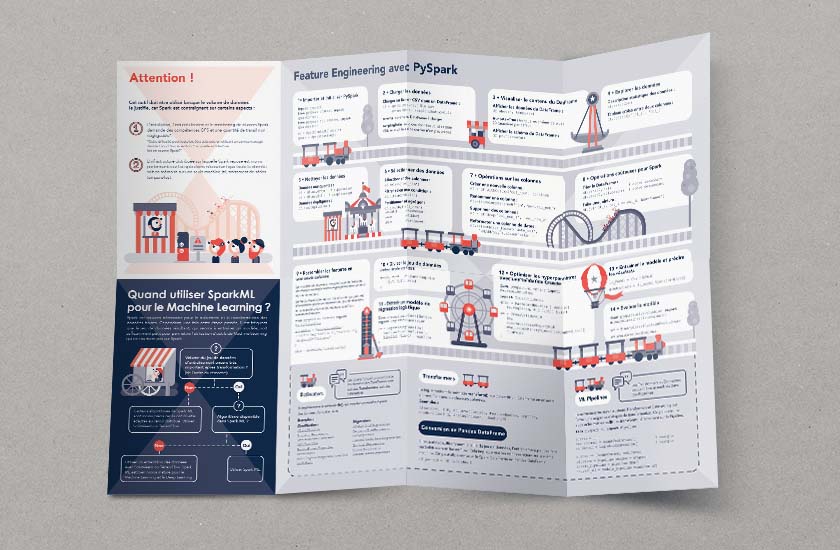

Cette Cheat Sheet propose un tour d'horizon des possibilités de cet outil et répondra aux principales questions que pourra se poser un data scientist : l'utilisation de Spark est-elle pertinente dans tel ou tel cas ? Dans quelle mesure et avec quelles limites ? Pour quel type de dataset ?

Sur quelle architecture fait-on tourner Spark ?

Comment fonctionne Spark ?

Qu'est-ce que Spark apporte au Data Scientist ?

L'évolution de Spark

Version 3.0.121 (Build officiel)